1,进入ollama官网选择 对应的系统 下载包

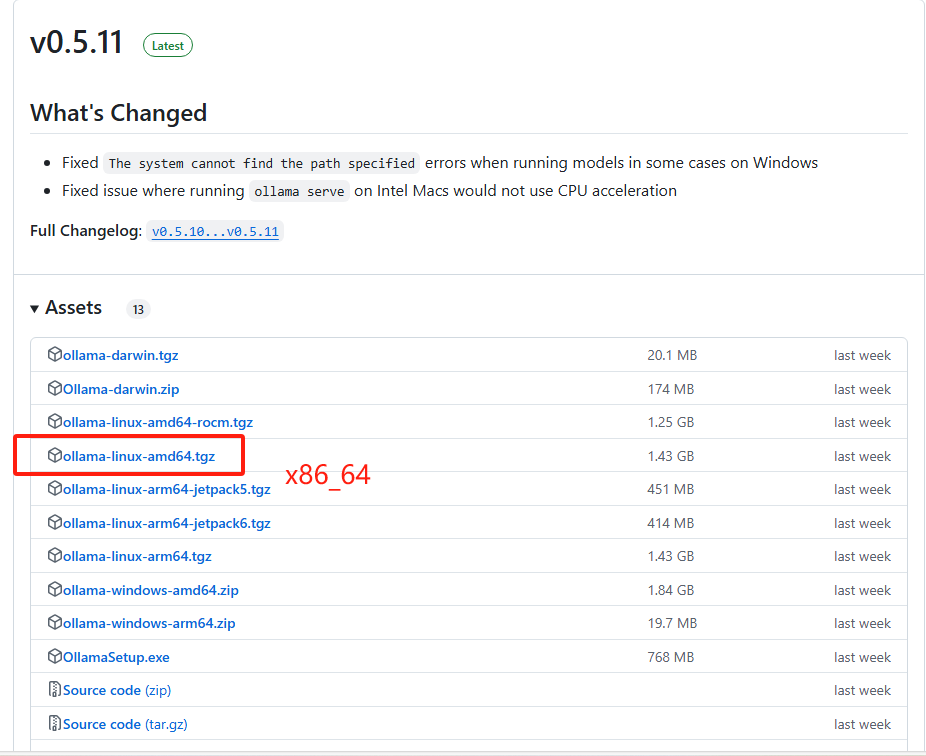

由于我们是离线安装进入 https://github.com/ollama/ollama/releases/ 选择自己的系统架构进行安装

# x86_64 CPU选择下载ollama-linux-amd64

# aarch64|arm64 CPU选择下载ollama-linux-arm64

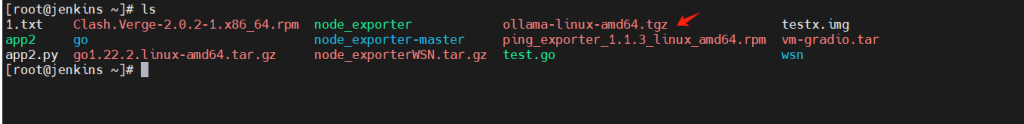

下载好后把包上传到服务器上

2,安装ollama

创建一个目录 叫ollama 把包移动到ollama目录下

mkdir /ollama && mv ollama-linux-amd64.tgz /ollama解压ollama包

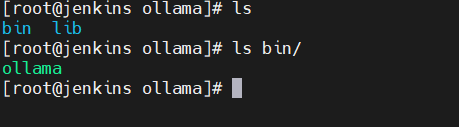

tar -zxvf ollama-linux-amd64.tgz解压完成后,会有 2个目录,bin是启动文件(主要文件)

3,创建一个systemd守护进程

vim /etc/systemd/system/ollama.service[Unit]

Description=Ollama AI Server

After=network.target

[Service]

ExecStart=/ollama/bin/ollama serve

WorkingDirectory=/ollama/bin

User=root

Group=root

Restart=always

RestartSec=3

Environment=PATH=/usr/bin:/usr/local/bin:/ollama/bin

Environment="OLLAMA_MODELS=/ollama/models" #指定 模型存放目录

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

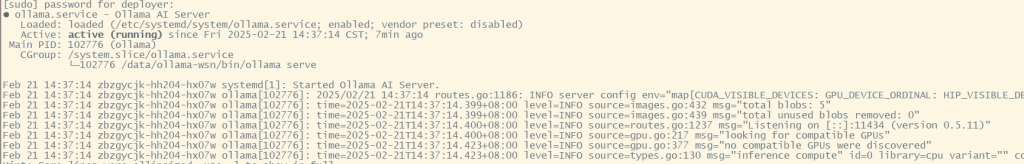

WantedBy=multi-user.target4,启动ollama

sudo systemctl daemon-reload

sudo systemctl enable ollama.service --now

5,离线安装大模型

因为我们的服务器是完全内网环境,所以即便安装ollama后也无法下载大模型,因此需要我们手动将模型放到ollama可以识别的地方。

默认情况下ollama模型的所在路径为:

macOS: ~/.ollama/models

Linux: **/usr/share/ollama/.ollama/models**

Windows: C:Users<username>.ollamamodels接下来,找一个可以上网的主机,执行ollama run ***,当大模型下载完成后,找到models目录,将整个目录拷贝到服务器你新创建的路径下。

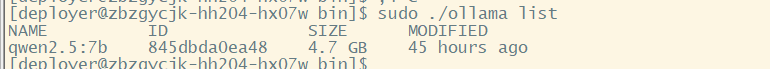

重启ollama,之后再执行ollama list命令,如果看到有模型了,证明搞定。

No Comments